OpenAI的最新研究将其机器学习代理放在一个简单的捉迷藏游戏中。他们进行了一场巧妙的军备竞赛,以意想不到的方式利用物体来达到被看见或看见的目的。这种自学的AI在现实世界中可能也很有用。

本研究旨在并成功探索机器学习代理学习复杂和现实世界相关技术的可能性,而不干扰研究人员的建议。

识别照片中的物体或发明合理的面孔等任务既困难又有用,但它们不能真正反映人们在现实世界中可能采取的行动。你可能会说他们智力高,所以即使不离开电脑也能达到高效率。

试图训练AI用机械臂拿着杯子放在茶托里的难度比人们想象的要大得多(而且只能在非常特殊的情况下才能做到);现实中,物理世界的复杂性使得单纯依靠计算机进行任务学习几乎是不可能的。

同时,中间任务可能不能完全反映现实世界,但它们仍然可以与现实世界相关。一个简单的方法可能是当有许多相关的物体或角色时,如何改变机器人的脸。你不需要做1000个物理实验就能知道它是应该自己旋转还是旋转相机让它能看到和旋转,或者在它们之间切换等等。

OpenAI对其婴儿ML代理的捉迷藏挑战遵循以下原则:一个规则简单的游戏环境(称为Polyworld),但仍然使用与真实世界相邻的物理方法和输入。如果人工智能可以自学如何驾驭简化的现实,也许他们可以将这些技能(经过一些修改)转移到成熟的现实中。

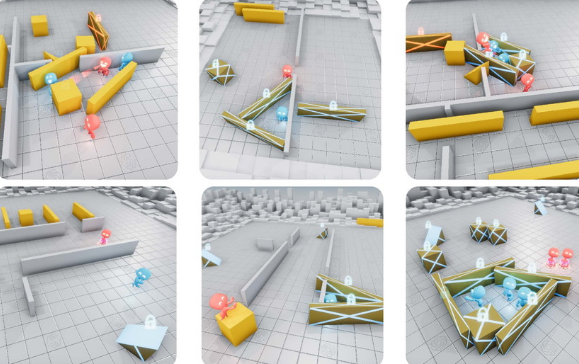

不管怎样,这是实验背后的想法,但它本身很有趣。游戏是在一个由随机生成的墙壁和物体组成的小型3D竞技场中进行的,这使得两个团队相互对抗。其中生成多个代理,给“隐藏人”几秒钟时间熟悉环境并隐藏。它们还可以与物体互动,将它们推来推去,并将它们锁定在适当的位置。一旦“搜索者”抬头,他们将有一些时间来找到他们。

所有的机器学习程序只知道基本的感觉——每个代理都有一个世界观和一个“激光雷达”,告诉他们附近物体的位置——以及他们对移动物体的知识。但除此之外,他们只是获得了成功或捉迷藏的机会,这就是他们的动机。

从这些基础开始已经产生了有趣的结果。首先,团队基本上是随机移动的。然而,在数百万场比赛中,隐藏者发现他们可以通过某种方式逃跑来更频繁地提高分数。然后军备竞赛开始了。

随着遮瑕膏的逃脱,探索者开始发展更有组织的追击。但是后来工具来了。

隐藏者发现他们可以在野外推拉物体,并开始在上面建造堡垒。

探索者的反应是使用野外发现的斜坡来提升物体并摧毁堡垒。

当探索者还在数的时候,道奇队开始寻找坡道,要么偷走坡道,要么把坡道锁在原地(对方球队的特工无法解开锁)。有趣的是,这涉及到一定程度的分工,因为两个躲藏的人通常没有足够的时间出去寻找坡道。一个必须准备堡垒,而另一个必须巡逻坡道。

OpenAI团队以为这就是结局,但探索者学会了利用游戏世界意想不到的功能。他们发现骑在箱子上时可以“推”箱子,这意味着他们可以把箱子放在斜坡附近,爬上去,然后“冲浪”整个场地,找到那些淘气的藏身之处。

当然,隐藏者的回应是锁定所有他们没有用来建造堡垒的物品,这似乎是游戏中策略的终结。

那有什么意义?正如本文作者所解释的,我们就是这样出现的。

由于自然选择引导的生物间的共同进化和竞争,地球上产生了大量的复杂性和多样性。当一种新的成功策略或变异出现时,会改变相邻代理需要解决的隐含任务分配,带来新的适应压力。这些进化军备竞赛创造了隐含的自动课程,因此竞争主体不断为彼此创造新的任务。

在具有物理基础和开放性的环境中引入自动课程,最终可能使代理获得无数与人相关的技能。

换句话说,让人工智能模型在无人监督的情况下竞争可能是开发有用且强大技能的更好方法,而不是让它们四处游荡并积累抽象数字,如探索环境的百分比。

通过参数化和控制AI和ring

境的交互作用,人们越来越难甚至不可能指导AI的各个方面。对于像机器人在拥挤的环境中导航这样的复杂任务,有太多因素导致人为设计行为可能永远不会产生这些特工在日常生活中所必需的那种复杂性。

但是,正如我们在这里和GAN中所看到的那样,它们可以互相教teach,一对决斗的AI在创建或检测现实媒体时相互击败。OpenAI研究人员认为,在许多其他方法过于缓慢或结构化的情况下,“多主体自动课程”或自教学代理是前进的道路。他们得出结论:

“这些结果激发了人们的信心,即在更加开放和多样化的环境中,多主体动态可能会导致极其复杂且与人类相关的行为。”